生成AIの急速な進化により、私たちは今、これまでにないほど自然でインタラクティブな対話体験を享受できる時代に突入しました。その中心にあるのが、ChatGPTに代表される対話型AIです。

では、なぜ今「自分だけのチャットボット」を作る必要があるのでしょうか? それは、目的に応じた柔軟な応答、個性を持った会話、そして独自サービスへの統合など、カスタマイズされたAIがもたらす価値が極めて高いからです。

このガイドでは、OpenAIのChatGPT APIを用いて、ゼロからオリジナルのAIチャットボットを構築するプロセスを丁寧に解説します。Pythonをベースとしながら、Webインターフェース、デプロイ、運用ノウハウまでステップバイステップでご紹介します。

📑 目次

- 1. 対話型AIの時代:なぜ今、チャットボットを作るのか?

- 2. 準備事項:APIキーの取得と環境構築

- 3. ChatGPT APIの構造を理解する

- 4. 最初のチャットボットを実装する

- 5. コンテキスト管理とロール設定による高度化

- 6. Webベースのチャットインターフェースを構築

- 7. クラウドへのデプロイと運用管理

- 8. 実運用のための最適化とベストプラクティス

- 9. 自分で作るAIチャットボットの意義とは?

1. 対話型AIの時代:なぜ今、チャットボットを作るのか?

近年、生成型AIは日常のあらゆるシーンで活用されるようになり、その中でも「対話型AI」は、ユーザーとの自然なやり取りを可能にする革新的な技術として注目されています。業務自動化、教育支援、パーソナルアシスタント、カスタマーサポートなど、応用範囲は急速に広がっています。

しかし、市販のチャットボットサービスでは応答の内容や性格を細かく制御できないことが多く、自社サービスとの連携や目的特化には限界があります。そこで必要となるのが、APIを活用して自分自身で設計・実装するチャットボットです。

このポストでは、以下のような疑問に実装を通じて答えていきます:

- ChatGPT APIはどのように動作するのか?

- 実装に必要なツールや準備とは?

- Web経由で誰でも使えるボットをどう作るのか?

読み終える頃には、あなた自身の手で動くAIチャットボットを構築できるだけでなく、それをどのように拡張し、発展させていけるかの道筋も見えてくるはずです。

2. 準備事項:APIキーの取得と環境構築

AIチャットボットを構築する前に、まずは必要な準備を整える必要があります。このセクションでは、OpenAI APIキーの取得方法、開発に必要なツールやライブラリの導入方法、そして動作確認までをステップバイステップでご紹介します。

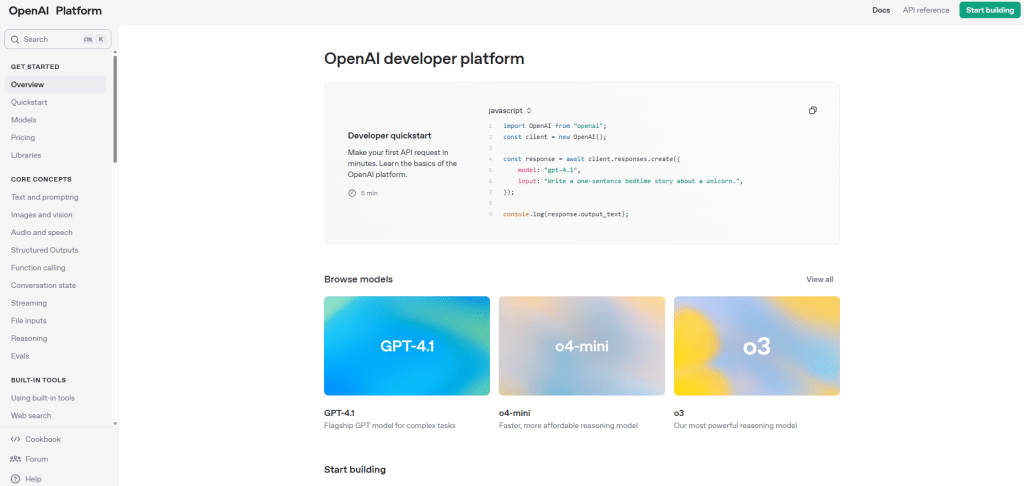

2-1. OpenAI APIキーの取得

まず、ChatGPT APIを使用するには、OpenAIから発行される「APIキー」が必要です。以下の手順に従ってキーを取得しましょう。

- OpenAI公式サイトにアクセスし、アカウントを作成またはログインします。

- ダッシュボード上部のメニューから「API Keys」を選択します。

- 「Create new secret key」ボタンをクリックし、表示されたキーをコピーして安全な場所に保管してください。

注意:このキーは個人に紐づく重要な情報です。ソースコードに直接書かず、環境変数として管理することが推奨されます。

2-2. 開発環境の準備

今回の実装ではPythonを使用します。以下のツールがインストールされていることを確認してください:

- Python 3.8以上

- pip(Pythonパッケージ管理ツール)

- 任意のコードエディタ(VSCode、PyCharmなど)

必要なライブラリは以下のコマンドで一括インストール可能です:

pip install openai python-dotenv flask2-3. 環境変数ファイル(.env)の設定

セキュリティの観点から、APIキーは.envファイルに保存し、コード内では環境変数として読み込みます。

OPENAI_API_KEY=ここに取得したAPIキーを入力次に、Pythonコード内でこの変数を読み込むように設定します:

from dotenv import load_dotenv

import os

load_dotenv()

api_key = os.getenv("OPENAI_API_KEY")2-4. APIの接続テスト

環境が正しく構成されているか確認するために、以下のコードでChatGPTと簡単な対話を試してみましょう。

import openai

from dotenv import load_dotenv

import os

load_dotenv()

openai.api_key = os.getenv("OPENAI_API_KEY")

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[

{"role": "user", "content": "こんにちは、あなたは誰ですか?"}

]

)

print(response["choices"][0]["message"]["content"])このスクリプトを実行して、ChatGPTからの応答がコンソールに表示されれば、準備完了です。

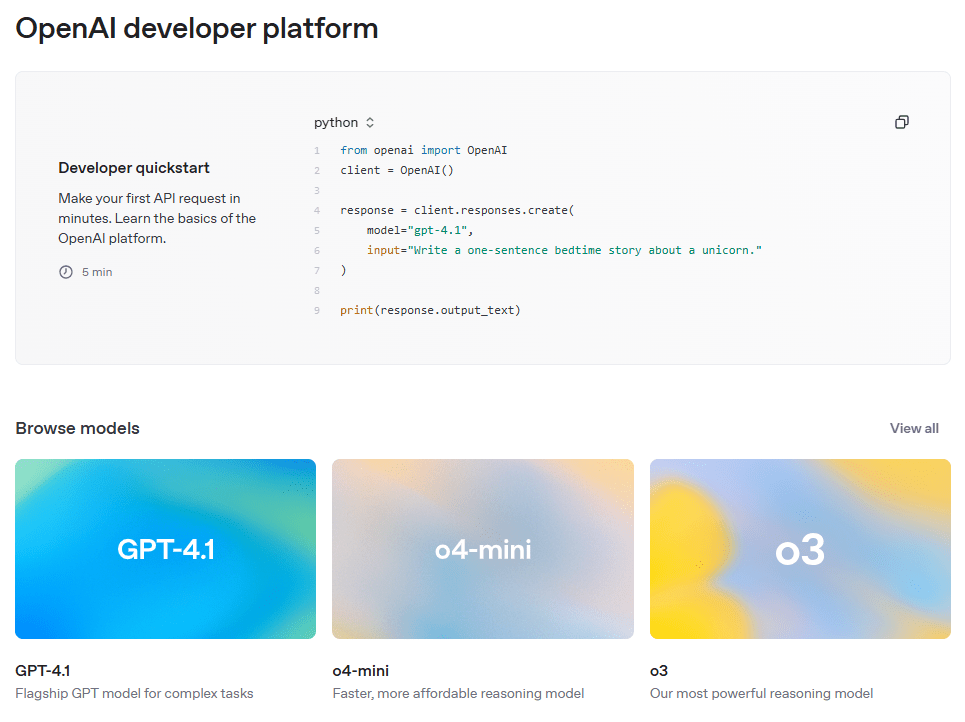

3. ChatGPT APIの構造を理解する

ChatGPT APIは非常にシンプルでありながら柔軟性の高い設計になっています。主に使用されるのはChatCompletionエンドポイントで、これはユーザーとAIの自然な会話のやり取りを可能にします。

3-1. API呼び出しの基本構造

以下は、ChatGPT APIへの基本的なリクエスト構造です。単一のメッセージを送信し、AIからの応答を受け取ります。

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[

{"role": "user", "content": "こんにちは、あなたは誰ですか?"}

]

)messagesパラメータは、会話の履歴を保持するリスト形式のオブジェクトであり、user、assistant、systemという3つの役割(role)を使って、対話の流れを管理します。

3-2. 主要パラメータの解説

ChatCompletion APIでよく使用されるパラメータは以下の通りです。

| パラメータ | 説明 |

|---|---|

| model | 使用するモデル名(例:gpt-3.5-turbo、gpt-4) |

| messages | 対話の履歴を格納するリスト形式のデータ(各項目にroleとcontentを含む) |

| temperature | 応答のランダム性(0.0〜1.0)を制御。低いほど論理的、高いほど創造的 |

| max_tokens | 生成される応答の最大トークン数を制限 |

| top_p | 確率の高いトークンを優先する「確率質量」での制御(nucleus sampling) |

| stop | 指定した文字列が出現したら応答を停止 |

3-3. GPT-3.5とGPT-4の比較

OpenAIは複数のモデルを提供しています。ここでは、代表的なgpt-3.5-turboとgpt-4を比較してみましょう。

| 項目 | GPT-3.5 Turbo | GPT-4 |

|---|---|---|

| 速度 | 高速 | やや遅い |

| 応答の質 | 標準的 | 非常に高精度 |

| コスト | 安価 | 高価 |

| 適用例 | 日常会話、プロトタイプ作成 | 業務用、専門的なタスク |

コストと性能のバランスを考慮すると、まずはgpt-3.5-turboで開発を開始し、必要に応じてgpt-4に切り替えるのが一般的です。

これでChatGPT APIの基礎構造について理解できました。次は、実際にPythonでシンプルなチャットボットを作ってみましょう。

4. 最初のチャットボットを実装する

ChatGPT APIの仕組みが理解できたところで、いよいよ自分の手でチャットボットを実装してみましょう。ここでは、最もシンプルな「ターミナルベース」のチャットボットを作成し、実際にAIとの対話を体験します。

4-1. シンプルな対話型チャットボットの構築

以下のコードは、ユーザーからの入力を受け取り、その内容をChatGPTに送信し、AIからの応答を表示するという基本構造です。

import openai

from dotenv import load_dotenv

import os

load_dotenv()

openai.api_key = os.getenv("OPENAI_API_KEY")

def chat_with_gpt():

print("AIチャットボットと対話を開始します。'exit'と入力すると終了します。")

while True:

user_input = input("あなた:")

if user_input.lower() == "exit":

print("チャットボットを終了します。")

break

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": user_input}]

)

reply = response["choices"][0]["message"]["content"]

print(f"GPT:{reply}")

chat_with_gpt()このプログラムの基本的な流れは以下の通りです:

- ユーザーの入力を受け取る

- その入力をChatGPT APIに送信

- 返ってきた応答をコンソールに表示

4-2. コード解説

load_dotenv():.envファイルからAPIキーなどの環境変数を読み込みます。ChatCompletion.create():ChatGPTモデルにメッセージを送信する主要な関数です。messages:対話内容を格納するリスト。今回は1メッセージのみを送信しています。response["choices"][0]["message"]["content"]:応答メッセージを取得して表示します。

4-3. 実行例

以下は、実際にこのチャットボットを使用した際の出力例です。

あなた:こんにちは!

GPT:こんにちは!どのようにお手伝いできますか?

あなた:日本の首都はどこですか?

GPT:日本の首都は東京です。

あなた:exit

チャットボットを終了します。4-4. 実装のヒント

- 長い応答に対応するために、画面表示のスクロール処理を検討してもよいでしょう。

- エラー処理(例:APIエラーやネットワーク切断)を追加すると、より実用的なボットになります。

- このコードはシンプルな構造なので、後の拡張(履歴保持、UI接続など)のベースとして使いやすいです。

これで、最初のChatGPTチャットボットの構築が完了しました。次のステップでは、このボットに記憶力(コンテキスト)と性格(ロール)を与えて、より高度な対話ができるように進化させていきます。

5. コンテキスト管理とロール設定による高度化

これまでに作成したチャットボットは、毎回ユーザーの入力に対して単発で応答する構成でした。しかし、実際の会話では「文脈(コンテキスト)」を維持しながらやり取りすることが重要です。また、チャットボットに「性格」や「役割(ロール)」を設定することで、より一貫性のある魅力的なAIに進化させることができます。

5-1. コンテキスト(会話履歴)を保持する

ChatGPTは内部的に過去のメッセージを保持しないため、開発者側で過去のやり取り(messages)をすべてAPIに送信する必要があります。以下のコードでは、ユーザーとGPTの会話履歴を順次追加しながら対話を継続します。

import openai

from dotenv import load_dotenv

import os

load_dotenv()

openai.api_key = os.getenv("OPENAI_API_KEY")

def chat_with_context():

messages = []

print("会話履歴を保持したチャットを開始します。'exit'で終了。")

while True:

user_input = input("あなた:")

if user_input.lower() == "exit":

print("チャットを終了します。")

break

messages.append({"role": "user", "content": user_input})

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=messages

)

reply = response["choices"][0]["message"]["content"]

print(f"GPT:{reply}")

messages.append({"role": "assistant", "content": reply})

chat_with_context()このように、ユーザーとアシスタントの両方の発言をリストに追加することで、コンテキストを維持しながら自然な対話を続けることができます。

5-2. systemロールでボットの性格・役割を定義する

systemロールを使うと、チャットボットに「どのように振る舞うか」を指示できます。これは会話開始時の最初のメッセージとして挿入します。

messages = [

{"role": "system", "content": "あなたはとても親切な日本語教師です。初心者に対して分かりやすく丁寧に説明してください。"}

]これにより、GPTは一貫したトーンと専門性を持って応答するようになります。さまざまなユースケースに応じてロールを設定してみましょう。

5-3. よく使われるロール設定の例

| チャットボットの種類 | systemメッセージ例 |

|---|---|

| ITサポート担当 | “あなたは初心者にも分かりやすく説明するITサポートスタッフです。” |

| カジュアルな友達 | “あなたは冗談を交えながら話す、親しみやすい友人のような存在です。” |

| ビジネスアシスタント | “あなたは礼儀正しいビジネスアシスタントとして、丁寧な言葉で対応してください。” |

5-4. 応答スタイルを微調整するパラメータ

以下のパラメータを使って、応答の「雰囲気」や「長さ」をコントロールすることができます:

temperature:0.0に近づくほど論理的、1.0に近づくほど創造的・ランダムmax_tokens:応答の最大長を設定top_p:確率が高いトークンを優先(nucleus sampling)

これらの機能を活用することで、単なる「会話応答」ではなく、目的や対象に合わせて最適化されたAIパートナーを作ることができます。

次は、このチャットボットをWeb上で誰でも使える形にするために、Flaskを使ったWebインターフェースの構築に進みましょう。

6. Webベースのチャットインターフェースを構築

これまでに構築したチャットボットはターミナル上で動作するものでしたが、実際のユーザーに提供するにはWebインターフェースが不可欠です。このセクションでは、PythonのFlaskを使って簡単なWebチャットボットを構築し、ブラウザ上で誰でも対話できるようにします。

6-1. プロジェクト構成

以下のようにディレクトリとファイルを整理します。

web-chatbot/

│

├── app.py # Flaskバックエンド

├── .env # APIキーなどの環境変数

├── templates/

│ └── index.html # HTMLインターフェース

└── static/

└── style.css # スタイリング用CSS6-2. Flaskアプリの実装(app.py)

FlaskでPOSTリクエストを受け取り、ChatGPT APIへ送信して応答を返す処理を実装します。

from flask import Flask, render_template, request, jsonify

from dotenv import load_dotenv

import openai

import os

load_dotenv()

openai.api_key = os.getenv("OPENAI_API_KEY")

app = Flask(__name__)

@app.route("/")

def index():

return render_template("index.html")

@app.route("/chat", methods=["POST"])

def chat():

user_message = request.json["message"]

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": user_message}]

)

reply = response["choices"][0]["message"]["content"]

return jsonify({"reply": reply})

if __name__ == "__main__":

app.run(debug=True)6-3. HTMLテンプレート(templates/index.html)

チャットボックスと入力欄、送信ボタンを備えた基本的なユーザーインターフェースをHTMLで構築します。

<!DOCTYPE html>

<html lang="ja">

<head>

<meta charset="UTF-8">

<title>AIチャットボット</title>

<link rel="stylesheet" href="/static/style.css">

</head>

<body>

<div class="chat-container">

<div id="chat-box"></div>

<input type="text" id="user-input" placeholder="メッセージを入力してください..." />

<button onclick="sendMessage()">送信</button>

</div>

<script>

async function sendMessage() {

const input = document.getElementById("user-input");

const message = input.value;

input.value = "";

const chatBox = document.getElementById("chat-box");

chatBox.innerHTML += "<div><strong>あなた:</strong> " + message + "</div>";

const response = await fetch("/chat", {

method: "POST",

headers: { "Content-Type": "application/json" },

body: JSON.stringify({ message: message })

});

const data = await response.json();

chatBox.innerHTML += "<div><strong>GPT:</strong> " + data.reply + "</div>";

chatBox.scrollTop = chatBox.scrollHeight;

}

</script>

</body>

</html>6-4. CSSスタイル(static/style.css)

簡易的なスタイルでチャット画面を整えます。

body {

font-family: Arial, sans-serif;

padding: 40px;

}

.chat-container {

max-width: 600px;

margin: 0 auto;

}

#chat-box {

border: 1px solid #ccc;

height: 300px;

padding: 10px;

overflow-y: auto;

margin-bottom: 10px;

}

#user-input {

width: 75%;

padding: 10px;

}

button {

padding: 10px 15px;

}6-5. 実行とテスト

Flaskアプリを起動し、ブラウザで http://localhost:5000 にアクセスすれば、チャットボットが使用可能になります。

これで、Webブラウザ上で動作するチャットインターフェースの基本が完成しました。次はこのアプリケーションをクラウドにデプロイし、誰でもアクセスできるようにしていきます。

7. クラウドへのデプロイと運用管理

Webベースのチャットボットが完成したら、次はそれをインターネット上に公開しましょう。つまり、誰でもアクセス可能な状態にする「クラウドへのデプロイ」が必要です。このセクションでは、無料で利用可能なクラウドホスティングサービス「Render」を例にして、実際のデプロイ手順と運用の注意点を解説します。

7-1. Renderを使ったデプロイ手順

RenderはGitHubと連携して簡単にPython Webアプリをデプロイできるクラウドサービスです。以下の手順でデプロイできます。

- Renderにログインし、[New] → [Web Service]をクリックします。

- GitHubと連携し、対象のリポジトリを選択します。

- 以下の設定を入力します:

- Build Command:

pip install -r requirements.txt - Start Command:

python app.py - Runtime: Python 3.10 以上

- Build Command:

- Environment Variablesに

OPENAI_API_KEYを追加し、.envの内容を登録します。

Renderではポート番号を環境変数として渡してくるため、Flaskの起動コードを以下のように変更しておくと安全です:

if __name__ == "__main__":

app.run(host="0.0.0.0", port=int(os.environ.get("PORT", 5000)))数分でデプロイが完了し、Renderから提供されるURLでアプリケーションにアクセスできるようになります。

7-2. APIキーの安全な管理

APIキーは第三者に漏洩すると悪用されるリスクがあります。以下のセキュリティ対策を徹底してください:

.envファイルはGitにコミットしない(.gitignoreに追加)- クラウド上では環境変数(Environment Variables)でAPIキーを登録

- 開発用と本番用で異なるAPIキーを使用する

7-3. エラーハンドリングとログの活用

実運用ではAPIの失敗、タイムアウト、ネットワークエラーなどが発生します。下記のようにエラーハンドリングを行い、ユーザーに丁寧なメッセージを返すようにしましょう。

try:

response = openai.ChatCompletion.create(...)

reply = response["choices"][0]["message"]["content"]

except openai.error.RateLimitError:

reply = "リクエストが多すぎます。少し待ってから再試行してください。"

except openai.error.AuthenticationError:

reply = "APIキーの認証に失敗しました。設定をご確認ください。"

except Exception as e:

reply = f"予期しないエラーが発生しました:{str(e)}"また、ログを出力することで障害時の原因追跡が容易になります。Flaskではloggingモジュールなどを活用できます。

7-4. その他のデプロイ先候補

Render以外にも以下のようなクラウドサービスがあります。用途に応じて選びましょう:

- Railway: データベースとの連携が容易で、初心者にも扱いやすい

- Vercel: フロントエンド特化。バックエンドはServerless構成に対応

- Replit: ブラウザ上で開発・デプロイ可能。学習用に最適

ここまでで、あなたのチャットボットはクラウドに公開され、誰でもアクセス可能な形となりました。次のセクションでは、実際の運用を通じて得た最適化のコツと、ベストプラクティスをご紹介します。

8. 実運用のための最適化とベストプラクティス

チャットボットを本番環境で運用するにあたっては、開発段階とは異なる課題が多数発生します。例えば、APIの使用量に伴うコスト管理、応答速度の最適化、障害対応などです。このセクションでは、実践的な運用に役立つ最適化のテクニックやベストプラクティスをご紹介します。

8-1. トークン使用量の抑制とコスト管理

OpenAIの料金は「トークン数」に基づいて計算されます。以下の工夫で無駄なトークン消費を避け、コストを最適化できます。

- モデル選定: gpt-3.5はgpt-4に比べて格段に安価です。

- 会話履歴の制限: 古いメッセージは削除または要約することでトークンを節約

- max_tokensの設定: 必要以上に長い応答を生成しないようにする

トークンの使用状況はAPIレスポンスから以下のように確認できます:

response = openai.ChatCompletion.create(...)

print(f"使用トークン数:{response['usage']['total_tokens']}")8-2. 応答速度の改善

応答が遅いとユーザー体験が損なわれます。以下のような対応が有効です:

- 履歴の最小化: 会話の前後関係に必要な部分のみ送信

- 質問の簡素化: 明確で短い質問の方が高速に処理されやすい

- gpt-3.5-turboの活用: gpt-4より高速な応答が可能

また、タイムアウト設定も応答遅延を防ぐのに役立ちます:

openai.ChatCompletion.create(..., timeout=10)8-3. エラーハンドリングの強化

運用中に発生し得るAPIエラーに対し、適切なメッセージを返すことでユーザー満足度を向上できます。

try:

response = openai.ChatCompletion.create(...)

reply = response["choices"][0]["message"]["content"]

except openai.error.RateLimitError:

reply = "リクエストが多すぎます。時間をおいて再試行してください。"

except openai.error.AuthenticationError:

reply = "APIキーが無効です。設定をご確認ください。"

except Exception as e:

reply = f"予期せぬエラーが発生しました:{str(e)}"8-4. よくある質問へのキャッシュ活用

FAQのように毎回同じ質問が繰り返される場合、APIを呼び出さずに事前にキャッシュした回答を返すことで効率化が図れます。

- メモリキャッシュ:

functools.lru_cacheの活用 - 永続キャッシュ:RedisやSQLiteを使用して頻出質問に対応

8-5. 拡張性を見据えた設計

チャットボットが広く使われるようになると、以下のような拡張も検討が必要です:

- ユーザーごとのセッション管理: 会話履歴をIDごとに保存

- アクセスログ・解析: 利用傾向を分析して改善に活かす

- 多言語対応: 言語識別と翻訳の導入

- 外部連携: SlackやLINE、Discordなどのメッセージングサービスとの統合

ここまでの最適化を行えば、チャットボットは単なる実験から実用的なプロダクトへと進化します。次のセクションでは、この取り組みの「意味」と「可能性」について振り返りましょう。

9. 自分で作るAIチャットボットの意義とは?

ここまでのステップを通じて、あなたはChatGPT APIを活用し、自らの手で実用的なAIチャットボットを構築しました。それは単なるプログラミングの練習ではなく、「生成AIという高度な技術を、現実の課題解決に活かす」という体験だったはずです。

このガイドで得られたもの

あなたは次のようなスキルと理解を得たはずです:

- OpenAI APIの基本構造と使用方法

- 会話履歴の管理とロールによる性格付け

- FlaskとHTML/CSS/JSによるWeb UI構築

- Renderを使ったクラウドデプロイの実践

- 運用中のパフォーマンス改善とセキュリティ対応

これはすべて、「誰でもAIを活用できる時代に、自分で創り出す力を持つ」という確かな自信につながるでしょう。

次に目指すべき方向

このチャットボットは完成ではなく、「始まり」です。今後、あなたが目指す方向性に応じて、次のような展開が可能です:

- Slack、LINE、Discordなどへのチャネル統合

- 社内ナレッジやFAQと連携する情報検索ボット(RAG構成)

- 音声認識や画像生成を組み合わせたマルチモーダル対応

- 教育・医療・金融など専門分野に特化したカスタムAI

このような未来のプロジェクトは、今日あなたが書いた一行のコードから始まります。

AIはもはや「使うもの」ではなく、「創るもの」です。

自分で構築したAIが、現実世界で誰かの役に立つとき、その意義と可能性は計り知れません。

さあ、次にあなたが創り出すAIはどんな世界を広げてくれるのでしょうか?

それは、あなた自身の想像力と行動が決める未来です。