인공지능이 일상 속으로 깊이 스며든 지금, 단순히 AI 기술을 ‘이해’하는 것만으로는 부족합니다. ‘직접 구현’해 보는 경험이 기술을 진짜 나의 것으로 만들죠. 이번 포스팅에서는 OpenAI의 ChatGPT API를 활용하여, 여러분만의 AI 챗봇을 만드는 전 과정을 상세히 안내합니다.

📑 목차

- 1. 대화형 AI의 시대, 왜 나만의 챗봇인가?

- 2. 사전 준비 사항

- 3. ChatGPT API 구조 이해하기

- 4. 첫 번째 챗봇: 기초 기능 구현

- 5. 고급 기능 추가하기

- 6. 사용자 친화형 웹 챗봇 만들기

- 7. 배포 및 운영 방법

- 8. 실전 팁과 유의사항

- 9. 결론: 내 손으로 만든 AI 챗봇의 의미

1. 대화형 AI의 시대, 왜 나만의 챗봇인가?

지금 우리는 ‘생성형 인공지능’이라는 전환기의 중심에 서 있습니다. 사람처럼 자연스럽게 대화하고, 맥락을 이해하며, 사용자 맞춤형 응답을 제공하는 챗봇은 더 이상 먼 미래의 기술이 아닙니다. 기업 고객 응대, 교육용 도우미, 개인 비서, 창작 도구 등 다양한 영역에서 활용되는 AI 챗봇은 단순한 기술을 넘어 실질적인 생산성과 경험을 혁신하고 있습니다.

그렇다면 왜 직접 챗봇을 만들어야 할까요? 바로 ‘맞춤형 AI’라는 가치 때문입니다. 오픈AI의 ChatGPT API를 이용하면, 특정 목적에 최적화된 대화형 인공지능을 구현할 수 있습니다. 예를 들어, 고객 지원에 특화된 답변을 제공하거나, 특정 지식 영역에서만 대화를 유도하도록 시스템을 설계할 수 있죠.

이번 글에서는 단순한 코드 나열이 아닌, 다음과 같은 핵심 질문을 함께 풀어나가며 실습을 진행할 것입니다.

- ChatGPT API는 어떻게 작동할까?

- 나만의 챗봇을 만들기 위해 어떤 준비가 필요할까?

- 웹 기반 챗봇은 어떻게 구성하고 배포할 수 있을까?

기초부터 실전까지 단계별로 안내하며, 직접 따라 해볼 수 있는 예제를 통해 개념과 구현이 어떻게 연결되는지 생생하게 체감할 수 있도록 도와드릴 예정입니다. 끝까지 함께하신다면, 단순한 흥미를 넘어 실질적인 구현 능력을 갖추게 될 것입니다.

2. 사전 준비 사항

본격적인 챗봇 구현에 앞서, OpenAI API를 활용하기 위한 준비 과정은 무척 중요합니다. 이 단락에서는 API 키 발급부터 개발 환경 구축까지, 실습을 위한 사전 작업을 하나하나 짚어보겠습니다.

2-1. OpenAI API 키 발급 방법

ChatGPT API를 사용하기 위해서는 OpenAI의 API 키가 필요합니다. 아래 절차에 따라 쉽게 발급받을 수 있습니다.

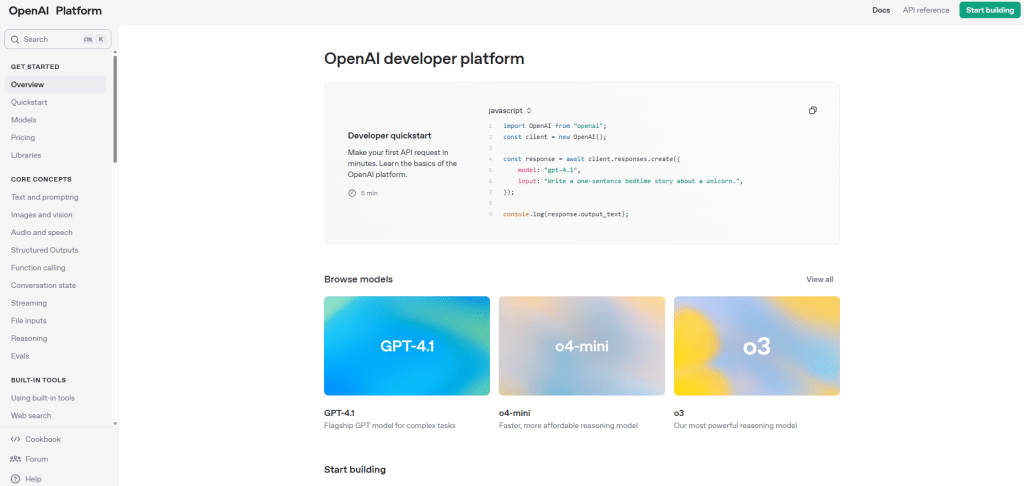

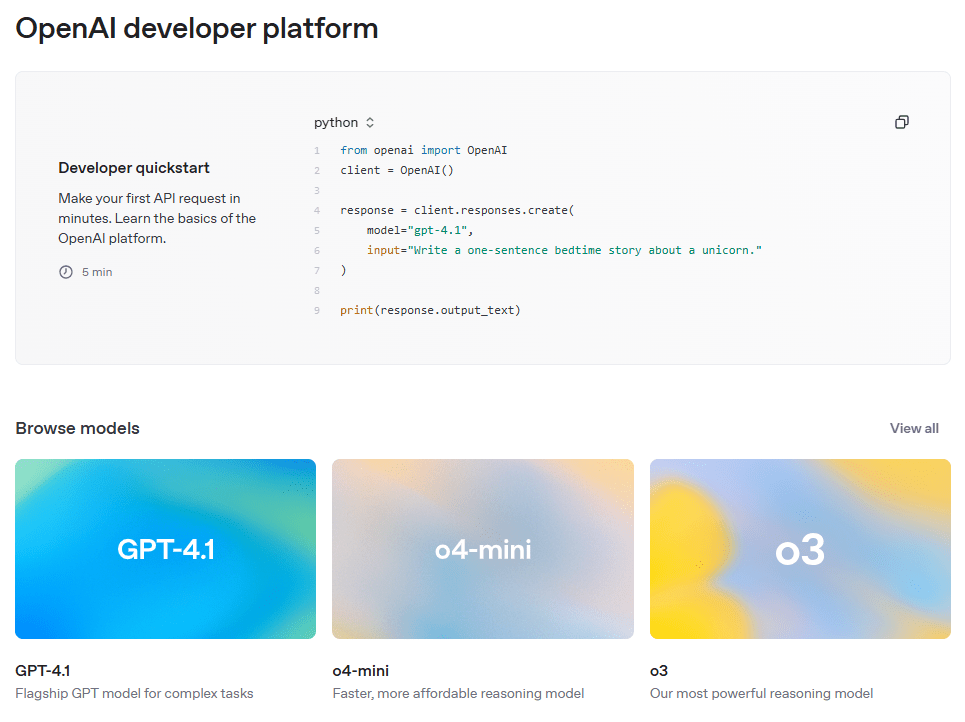

- OpenAI 개발자 사이트에 접속하여 회원가입을 합니다.

- 로그인 후 상단 메뉴에서 [API Keys] 항목을 선택합니다.

- [Create new secret key] 버튼을 눌러 키를 생성하고, 안전한 장소에 복사해둡니다.

주의: API 키는 노출 시 제3자가 비용을 발생시킬 수 있으므로, 코드에 직접 하드코딩하지 말고 환경변수나 비공개 설정 파일에 저장하세요.

2-2. 개발 환경 구축

Python 기반으로 챗봇을 구현할 예정이므로, 아래 구성 요소가 설치되어 있어야 합니다.

- Python 3.8 이상

- pip (Python 패키지 관리자)

- 코드 편집기 (VSCode, PyCharm 등)

필수 패키지 설치는 아래 명령어로 간단히 완료할 수 있습니다.

pip install openai python-dotenv flask2-3. 환경 변수 파일 설정 (.env)

API 키를 안전하게 관리하기 위해 환경 변수 파일을 사용하는 것이 좋습니다. 프로젝트 루트 디렉토리에 .env 파일을 생성하고 다음과 같이 작성합니다.

OPENAI_API_KEY=your_openai_api_key_here이후, Python 코드에서는 python-dotenv 라이브러리를 이용하여 API 키를 불러올 수 있습니다.

from dotenv import load_dotenv

import os

load_dotenv()

api_key = os.getenv("OPENAI_API_KEY")2-4. API 테스트를 위한 기본 Python 코드

API 키가 정상적으로 작동하는지 확인하기 위해, 다음과 같이 간단한 테스트 코드를 실행해봅니다.

import openai

from dotenv import load_dotenv

import os

load_dotenv()

openai.api_key = os.getenv("OPENAI_API_KEY")

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[

{"role": "user", "content": "Hello, who are you?"}

]

)

print(response["choices"][0]["message"]["content"])위 코드를 실행하면 ChatGPT가 사용자 메시지에 응답하는 결과를 확인할 수 있습니다. 이제 본격적으로 챗봇을 개발할 준비가 완료되었습니다.

3. ChatGPT API 구조 이해하기

OpenAI의 ChatGPT API는 간결하면서도 유연한 구조를 가지고 있어, 다양한 챗봇 기능을 빠르게 구현할 수 있도록 설계되어 있습니다. 이 단락에서는 API의 호출 방식, 핵심 파라미터, 그리고 모델 간의 차이점을 체계적으로 정리합니다.

3-1. API 호출 방식 개요

ChatGPT API는 기본적으로 RESTful API 방식으로 작동하며, POST 요청을 통해 대화 데이터를 전달하고 응답을 받습니다. 가장 기본적인 호출 포맷은 다음과 같습니다.

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[

{"role": "user", "content": "안녕, 너는 누구야?"}

]

)위 예시는 GPT-3.5 모델을 호출하여 단일 메시지에 대해 응답을 받는 간단한 구조입니다.

3-2. 주요 파라미터 설명

ChatCompletion API에서 사용하는 주요 파라미터는 아래와 같습니다.

| 파라미터 | 설명 |

|---|---|

| model | 사용할 모델명 (예: “gpt-3.5-turbo”, “gpt-4”) |

| messages | 대화 이력을 포함한 메시지 목록. 역할(role)과 내용(content)을 포함 |

| temperature | 응답의 창의성 조절 (0.0~1.0, 기본값 1.0) |

| max_tokens | 응답에서 생성될 최대 토큰 수 |

| top_p | 샘플링할 토큰의 누적 확률을 제한 (기본값: 1) |

| stop | 응답 생성을 중단할 문자열 (선택적) |

3-3. GPT-3.5 vs GPT-4: 어떤 모델을 쓸까?

OpenAI는 다양한 모델을 제공하고 있으며, 대표적으로 많이 사용되는 두 모델의 차이는 다음과 같습니다.

| 항목 | GPT-3.5 Turbo | GPT-4 |

|---|---|---|

| 속도 | 빠름 | 비교적 느림 |

| 정확도 | 보통 | 높음 (복잡한 작업에 유리) |

| 비용 | 저렴 | 비쌈 |

| 사용처 | 일반 대화, 테스트용 | 전문 챗봇, 고정밀 요구 |

초기에는 GPT-3.5로 시작해 보고, 프로젝트의 복잡성과 요구 수준에 따라 GPT-4로 확장하는 전략이 합리적입니다.

이제 ChatGPT API의 전반적인 구조와 동작 방식에 대한 이해를 갖추었으니, 다음 단계에서는 실제 챗봇 코드를 구현하며 실습을 진행해 보겠습니다.

4. 첫 번째 챗봇: 기초 기능 구현

이제 이론에서 실전으로 넘어갈 차례입니다. 이번 단락에서는 OpenAI의 ChatGPT API를 이용해 간단한 대화형 챗봇을 터미널 환경에서 구현해보겠습니다. 이 챗봇은 사용자의 메시지를 받아, ChatGPT의 응답을 출력하는 기본적인 기능을 수행합니다.

4-1. 챗봇 기본 코드 구현

아래는 사용자 입력을 받고 ChatGPT의 응답을 출력하는 가장 간단한 챗봇 예제입니다.

import openai

from dotenv import load_dotenv

import os

load_dotenv()

openai.api_key = os.getenv("OPENAI_API_KEY")

def chat_with_gpt():

print("AI 챗봇과 대화를 시작합니다. 'exit'을 입력하면 종료됩니다.")

while True:

user_input = input("당신: ")

if user_input.lower() == "exit":

print("챗봇을 종료합니다.")

break

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[

{"role": "user", "content": user_input}

]

)

reply = response["choices"][0]["message"]["content"]

print(f"GPT: {reply}")

chat_with_gpt()이 코드는 다음과 같은 흐름으로 작동합니다:

- 사용자로부터 입력을 받는다.

- 입력된 텍스트를 API에 전달한다.

- 응답 메시지를 받아 출력한다.

4-2. 코드 분석

openai.ChatCompletion.create(): GPT 모델을 호출하는 핵심 함수입니다.messages에는 단일 메시지를 리스트 형식으로 전달하고 있습니다. 추후 이력을 관리할 때 확장됩니다.response["choices"][0]["message"]["content"]: API의 응답 중 실제 텍스트 응답을 추출하는 구문입니다.

4-3. 실행 결과 예시

아래는 위 챗봇을 실행했을 때 나올 수 있는 예시 대화입니다.

당신: 안녕!

GPT: 안녕하세요! 무엇을 도와드릴까요?

당신: 오늘 날씨 어때?

GPT: 죄송합니다, 현재 날씨 정보를 직접 조회할 수는 없습니다. 하지만 인터넷에서 확인해 보실 수 있습니다.

당신: exit

챗봇을 종료합니다.4-4. 실습 팁

- 오류 발생 시

openai.error.OpenAIError예외 처리를 통해 메시지를 보다 명확히 파악할 수 있습니다. - 인터넷 연결이 필요하므로 방화벽이나 프록시 환경도 점검해 보세요.

- 기본적인 흐름을 익힌 후에는 점차 기능을 확장해 나가는 것이 좋습니다 (대화 이력, 캐릭터 성격 설정 등).

이 챗봇은 가장 단순한 형태지만, 구조는 이후에 고급 기능을 추가할 때에도 그대로 유지됩니다. 즉, 지금 다지는 기본기가 향후 확장 작업의 뼈대가 됩니다.

5. 고급 기능 추가하기

앞서 만든 챗봇은 사용자와 단발성 대화를 주고받는 형태였습니다. 이제 대화 흐름을 기억하고, 챗봇의 성격과 역할을 정의하여 더욱 지능적인 인터페이스를 구현해보겠습니다.

5-1. 대화 이력 유지: context 기억하기

OpenAI의 ChatGPT API는 이전 대화 맥락을 messages 리스트를 통해 기억합니다. 따라서 사용자가 어떤 말을 했는지, 챗봇이 어떤 답을 했는지를 모두 누적하여 전달해야 일관된 응답이 가능해집니다.

import openai

from dotenv import load_dotenv

import os

load_dotenv()

openai.api_key = os.getenv("OPENAI_API_KEY")

def chat_with_context():

messages = []

print("GPT와 대화를 시작합니다. 'exit'을 입력하면 종료됩니다.")

while True:

user_input = input("당신: ")

if user_input.lower() == "exit":

print("대화를 종료합니다.")

break

messages.append({"role": "user", "content": user_input})

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=messages

)

reply = response["choices"][0]["message"]["content"]

print(f"GPT: {reply}")

messages.append({"role": "assistant", "content": reply})

chat_with_context()이렇게 하면 챗봇은 이전 발언을 바탕으로 문맥에 맞는 답변을 제공할 수 있습니다.

5-2. 시스템 프롬프트를 통한 챗봇 성격 정의

ChatGPT API의 특별한 기능 중 하나는 system role 메시지를 통해 챗봇의 ‘성격’이나 ‘역할’을 정의할 수 있다는 점입니다. 예를 들어, 아래와 같이 정의할 수 있습니다.

messages = [

{"role": "system", "content": "당신은 역사 전문가입니다. 모든 답변은 역사적 사실에 기반해 주세요."}

]이 설정을 적용하면 GPT는 역사 전문가처럼 대화하며, 일반적인 일상 대화보다는 주제에 맞춰 정보 중심의 응답을 제공합니다. 다른 예시로는 다음과 같은 역할이 가능합니다:

- 제품 추천 도우미

- 어린이 대상 교육용 챗봇

- 비즈니스 이메일 작성 조력자

5-3. 다양한 역할 예시

다음은 실전에서 자주 사용되는 시스템 프롬프트 예시입니다.

| 챗봇 유형 | system 메시지 내용 |

|---|---|

| 친절한 IT 튜터 | “당신은 초보자를 대상으로 설명하는 친절한 IT 튜터입니다.” |

| 포멀한 비서 | “당신은 예의를 중요시하는 포멀한 말투의 비서입니다.” |

| 농담 잘하는 친구 | “당신은 유머러스한 대화를 즐기는 친근한 친구입니다.” |

이러한 설정은 단순한 지식 응답을 넘어, 챗봇을 하나의 ‘인격체’처럼 다룰 수 있도록 만들어 줍니다. 결국 사용자와의 몰입도 높은 상호작용을 끌어내는 핵심이 됩니다.

5-4. 응답 길이, 창의성 조절

아래 파라미터를 조절함으로써 챗봇의 응답 스타일을 미세 조정할 수 있습니다:

temperature: 낮을수록 응답이 논리적이고, 높을수록 창의적인 표현max_tokens: 챗봇의 응답 최대 길이 설정top_p: 응답의 다양성 제어 (샘플링의 폭)

이제 우리 챗봇은 단순한 문답을 넘어, 맥락을 이해하고, 역할을 수행하며, 말투까지 설정 가능한 ‘지능형 인터페이스’로 거듭났습니다. 다음 단계에서는 이를 웹 서비스로 확장해 보겠습니다.

6. 사용자 친화형 웹 챗봇 만들기

터미널 기반 챗봇이 기능을 익히는 데에는 유용하지만, 사용자와의 상호작용을 고려할 때는 웹 기반 인터페이스가 훨씬 효율적입니다. 이번 단락에서는 Flask를 활용해 간단한 웹 챗봇을 구축하고, HTML/CSS로 사용자 친화적인 UI를 구현하는 방법을 알아보겠습니다.

6-1. 프로젝트 구조 설계

먼저 디렉토리 구조를 아래와 같이 구성해 주세요.

web-chatbot/

│

├── app.py # Flask 서버

├── .env # 환경 변수(API 키 등)

├── templates/

│ └── index.html # 웹 페이지 템플릿

└── static/

└── style.css # 스타일시트6-2. Flask 서버 구현 (app.py)

Flask는 가볍고 직관적인 웹 프레임워크로, 챗봇의 요청을 처리하고 응답을 반환하는 데 적합합니다. 다음은 백엔드 서버 코드입니다.

from flask import Flask, render_template, request, jsonify

from dotenv import load_dotenv

import openai

import os

load_dotenv()

openai.api_key = os.getenv("OPENAI_API_KEY")

app = Flask(__name__)

@app.route("/")

def index():

return render_template("index.html")

@app.route("/chat", methods=["POST"])

def chat():

user_message = request.json["message"]

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": user_message}]

)

reply = response["choices"][0]["message"]["content"]

return jsonify({"reply": reply})

if __name__ == "__main__":

app.run(debug=True)6-3. HTML 템플릿 작성 (templates/index.html)

간단한 챗 인터페이스를 HTML로 구성합니다.

<!DOCTYPE html>

<html lang="ko">

<head>

<meta charset="UTF-8">

<title>AI 챗봇</title>

<link rel="stylesheet" href="/static/style.css">

</head>

<body>

<div class="chat-container">

<div id="chat-box"></div>

<input type="text" id="user-input" placeholder="메시지를 입력하세요..." />

<button onclick="sendMessage()">전송</button>

</div>

<script>

async function sendMessage() {

const input = document.getElementById("user-input");

const message = input.value;

input.value = "";

const chatBox = document.getElementById("chat-box");

chatBox.innerHTML += "<div><strong>나:</strong> " + message + "</div>";

const response = await fetch("/chat", {

method: "POST",

headers: { "Content-Type": "application/json" },

body: JSON.stringify({ message: message })

});

const data = await response.json();

chatBox.innerHTML += "<div><strong>GPT:</strong> " + data.reply + "</div>";

chatBox.scrollTop = chatBox.scrollHeight;

}

</script>

</body>

</html>6-4. 간단한 CSS 스타일 추가 (static/style.css)

body {

font-family: Arial, sans-serif;

margin: 50px;

}

.chat-container {

max-width: 600px;

margin: 0 auto;

}

#chat-box {

border: 1px solid #ccc;

height: 300px;

padding: 10px;

overflow-y: scroll;

margin-bottom: 10px;

}

#user-input {

width: 75%;

padding: 10px;

}

button {

padding: 10px 15px;

}6-5. 실행 및 테스트

Flask 앱을 실행한 뒤, http://localhost:5000 으로 접속하면 챗봇 웹페이지를 확인할 수 있습니다. 입력창에 메시지를 입력하고 버튼을 누르면 ChatGPT가 응답을 반환합니다.

이렇게 구현된 웹 챗봇은 기본적인 대화형 기능을 제공하며, 향후 다양한 확장도 가능하게 해 줍니다 (예: 사용자 로그인, 챗 로그 저장, 이미지 입력 등).

7. 배포 및 운영 방법

로컬에서 개발한 챗봇을 인터넷에서 누구나 접근할 수 있도록 하려면 클라우드 환경에 배포해야 합니다. 이 단락에서는 무료로 시작할 수 있는 클라우드 배포 플랫폼을 소개하고, API 키 보안 및 운영 시 유의사항까지 자세히 안내합니다.

7-1. Render를 이용한 배포

Render는 무료 플랜을 제공하며, GitHub 연동을 통해 매우 손쉽게 Flask 기반 웹앱을 배포할 수 있는 플랫폼입니다.

- Render에 가입한 뒤, New Web Service를 선택합니다.

- GitHub에 Push한 챗봇 프로젝트를 선택하고, 다음 항목을 설정합니다:

- Build Command:

pip install -r requirements.txt - Start Command:

python app.py - Environment: Python 3.10 이상 선택

- Build Command:

- Environment Variables 항목에서

OPENAI_API_KEY를 등록합니다. - 배포 후 제공되는 URL로 챗봇에 접근할 수 있습니다.

Render는 플라스크 앱을 기본 포트 10000번으로 실행하므로, app.py 코드에서 다음처럼 수정해줘야 할 수도 있습니다:

if __name__ == "__main__":

app.run(host="0.0.0.0", port=int(os.environ.get("PORT", 5000)))7-2. API 키 보안 관리

챗봇이 사용하는 OpenAI API 키는 외부에 절대 노출되어서는 안 됩니다. 몇 가지 권장 보안 조치입니다:

- .env 파일은 절대 Git에 포함시키지 마세요. →

.gitignore에 반드시 추가할 것 - 운영 환경에서는 환경 변수(Environment Variables)를 통해 키를 불러오도록 설정

- API 키를 여러 프로젝트에서 사용할 경우, 각 서비스별로 별도 키 생성 후 사용 권장

7-3. API 사용량 모니터링 및 예외 처리

OpenAI API는 사용량에 따라 요금이 발생하므로, 주기적으로 사용량을 모니터링하고 과금 기준을 파악하는 것이 중요합니다.

- OpenAI 대시보드에서 요청 수, 토큰 수, 비용 확인 가능

- API 호출에 실패할 경우를 대비한

try-except예외 처리 코드 필요

try:

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=messages

)

reply = response["choices"][0]["message"]["content"]

except openai.error.OpenAIError as e:

reply = f"API 호출 중 오류 발생: {str(e)}"또한, 지나치게 많은 요청이 발생하지 않도록 입력 길이 제한, 시간 간격 제어 등 간단한 로직을 추가하는 것도 좋은 방법입니다.

7-4. 대안 클라우드: Railway, Vercel, Replit

Render 외에도 다음과 같은 플랫폼에서 Flask 챗봇을 손쉽게 배포할 수 있습니다:

- Railway: 직관적인 UI와 빠른 배포 속도. PostgreSQL 등 DB 연동도 용이

- Vercel: 주로 React 등 정적 프론트엔드에 적합, 백엔드는 Serverless 방식으로 제한적

- Replit: 코드 에디터 내에서 실행부터 배포까지 가능. 학습용으로 적합

프로젝트의 규모와 사용 목적에 맞춰 적절한 플랫폼을 선택하세요. 챗봇을 운영 환경에 배포했다면, 이제 진정한 AI 서비스의 시작점에 선 것입니다.

8. 실전 팁과 유의사항

챗봇을 성공적으로 배포한 이후에도, 운영 중에는 다양한 이슈가 발생할 수 있습니다. 이 단락에서는 실전에 바로 적용 가능한 유용한 팁과 유의사항을 통해 챗봇의 성능과 효율을 동시에 끌어올리는 방법을 소개합니다.

8-1. 토큰 비용 계산과 절약 전략

OpenAI의 ChatGPT API는 입력과 출력에 사용된 토큰 수를 기준으로 요금이 부과됩니다. 따라서 다음 사항을 유념해야 합니다:

- model 선택에 따른 비용 차이: GPT-4는 GPT-3.5보다 약 10배 비쌉니다.

- 불필요한 대화 이력 생략: 오래된 메시지는 누락하거나 요약 처리

- max_tokens 파라미터 최적화: 응답의 길이를 불필요하게 길게 설정하지 않기

실제로 API 응답에는 다음과 같이 사용된 토큰 수가 포함되어 있어, 분석에 활용할 수 있습니다:

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=messages

)

usage = response["usage"]

print(f"총 사용 토큰: {usage['total_tokens']}")8-2. 속도 최적화 전략

챗봇의 응답이 느릴 경우, 사용자 만족도가 크게 떨어질 수 있습니다. 다음 방법들을 고려해 보세요:

- 모델 선택 최적화: 일반 대화용은 gpt-3.5-turbo 사용

- 대화 이력 최소화: 필수 메시지만 유지

- 질문 단순화: 복잡한 요청은 여러 단계로 나누어 처리

또한, 서버 측에서는 API 요청에 대한 timeout 값을 설정해 네트워크 지연에 대비하는 것이 좋습니다.

8-3. 예외 처리 및 사용자 피드백

API 호출 실패는 종종 발생합니다. 사용자는 문제의 원인을 정확히 알 수 없기 때문에, 다음과 같은 방식으로 친절한 오류 메시지를 안내하세요.

try:

response = openai.ChatCompletion.create(...)

reply = response["choices"][0]["message"]["content"]

except openai.error.RateLimitError:

reply = "현재 요청이 너무 많아 잠시 후 다시 시도해 주세요."

except openai.error.AuthenticationError:

reply = "API 인증에 실패했습니다. 관리자에게 문의하세요."

except Exception as e:

reply = f"예기치 못한 오류가 발생했습니다: {str(e)}"8-4. 캐싱 전략

자주 반복되는 질문에 대해서는 API를 호출하는 대신 캐시(메모리 또는 데이터베이스)에 저장된 응답을 제공함으로써 비용과 속도를 동시에 절약할 수 있습니다.

- 예: “회사 소개”, “업무 시간” 등의 FAQ는 캐시

- Python에서는

functools.lru_cache또는 Redis 사용 가능

8-5. 서비스 확장을 고려한 구조화

서비스가 성장함에 따라, 다음과 같은 기능을 고려해 구조를 점차 확장할 수 있습니다:

- 사용자별 대화 이력 저장 (SQLite, PostgreSQL 등 활용)

- 다국어 대응을 위한 언어 감지 및 변환

- 대화 내용 분석 및 추천 시스템 연동

실제 운영 환경은 단순한 테스트와는 전혀 다르기 때문에, 운영 친화적인 설계와 비상 대응 전략이 반드시 필요합니다.

9. 결론: 내 손으로 만든 AI 챗봇의 의미

우리는 이번 여정을 통해 단순한 ‘기능 구현’을 넘어, 실제 사용 가능한 지능형 챗봇을 직접 설계하고 구현하는 전 과정을 함께 경험했습니다. ChatGPT API의 구조를 이해하고, 기본적인 대화 흐름에서부터 고급 기능, 웹 UI, 그리고 클라우드 배포에 이르기까지—지금 여러분은 단지 코드를 따라한 초보자가 아니라, 하나의 AI 서비스를 설계한 ‘창작자’입니다.

직접 만든 챗봇은 단순한 도구가 아니라, 여러분의 사고방식, 기술적 판단, 창의력이 반영된 결과물입니다. 그리고 그것은 언제든 새로운 방향으로 확장될 수 있습니다.

예를 들어, 여러분은 지금 만든 챗봇에 다음과 같은 기능을 추가할 수 있습니다:

- 슬랙, 카카오톡, 디스코드 등 메신저 플랫폼 연동

- 지식 데이터베이스 기반의 질문응답 시스템 구축 (RAG)

- 이미지 생성, 음성 인식 등 멀티모달 기능 확장

이제 중요한 것은, 계속해서 만들어보는 것입니다. 실수를 두려워하지 말고, 때로는 비효율적이라 느껴지는 반복조차 여러분의 손에 기술을 새기게 할 것입니다. ‘만들 수 있다’는 감각은 경험으로부터 옵니다.

끝으로, 이 글을 끝까지 읽고 직접 실습하신 여러분에게 말씀드립니다.

여러분은 이미 AI 개발자로서의 첫걸음을 힘차게 내딛었습니다.

이제, 그 다음 걸음은 어디로 향할지, 스스로 정해보세요.

AI는 도구이고, 선택은 당신의 몫입니다.